Chept GPT作為近年來

人工智能領域的重要突破,引發了廣泛關注。它不僅在自然語言處理任務上取得了顯著成果,還讓我們對

人工智能的未來充滿了期待。本文將深入探討Chept GPT背后的技術奧秘,揭開其神秘的面紗。

首先,我們需要了解Chept GPT的基本原理。Chept GPT是一種基于變換器(Transformer)架構的預訓練語言模型,其核心思想是通過大規模語料庫對模型進行預訓練,從而學習到豐富的語言知識和結構。在預訓練過程中,Chept GPT采用了無監督學習的方法,即不需要人工標注的數據進行訓練。這種方法使得模型能夠自動從大量文本中學習到有用的信息。

接下來,我們來詳細解析Chept GPT的關鍵技術。

1. 變換器(Transformer)架構:Transformer是一種基于自注意力機制的深度神經網絡模型。它主要由編碼器(Encoder)和解碼器(Decoder)兩部分組成。在Chept GPT中,只使用了編碼器部分。編碼器由多個自注意力層和前饋神經網絡層組成,能夠有效地捕捉文本中的長距離依賴關系。

2. 預訓練目標:Chept GPT采用了兩種預訓練目標,分別是掩碼語言建模(Masked Language Modeling,MLM)和下一句預測(Next Sentence Prediction,NSP)。MLM任務是通過掩碼一部分單詞,讓模型預測被掩碼的單詞。這種方法能夠使模型學習到單詞的上下文信息。NSP任務則是讓模型預測兩個句子是否是連續的,從而學習到句子間的關系。

3. 位置編碼:為了使模型能夠理解文本中的順序信息,Chept GPT引入了位置編碼。位置編碼是一種將單詞位置信息編碼為向量并添加到詞向量中的方法。這樣,模型在處理文本時,可以同時考慮到單詞的順序和內容。

4. 層次化注意力機制:Chept GPT采用了層次化注意力機制,使得模型在處理長文本時,能夠更有效地捕捉關鍵信息。層次化注意力機制將文本劃分為多個層次,每個層次關注不同的信息。在處理每個層次時,模型會根據上下文信息動態調整注意力權重。

5. 微調(Fine-tuning):Chept GPT在預訓練完成后,還需要進行微調。微調是將預訓練模型應用于特定任務時,對模型進行少量調整的過程。通過微調,模型能夠更好地適應具體任務的需求。

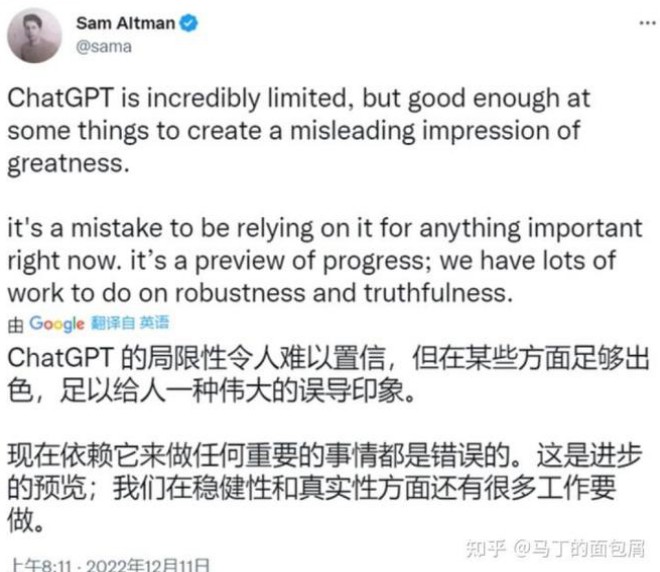

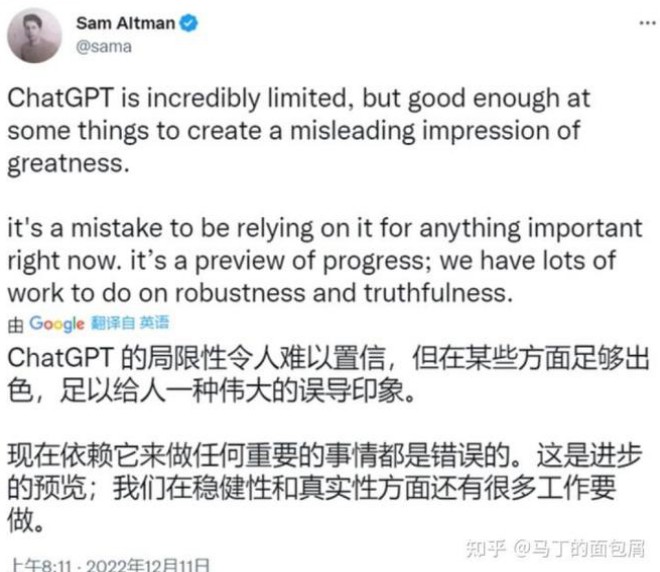

正是這些技術的巧妙結合,使得Chept GPT在自然語言處理任務上取得了優異的表現。然而,Chept GPT并非完美無缺。例如,它在處理長文本時仍然存在性能瓶頸,且對于一些復雜任務,其表現仍不如人類。未來,隨著技術的不斷發展,Chept GPT等預訓練語言模型有望在更多領域發揮重要作用,為

人工智能的進步貢獻力量。